- A+

我们都知道网络上的爬虫非常多,有对网站收录有益的,比如百度蜘蛛(Baiduspider),也有不但不遵守robots规则对服务器造成压力,还不能为网站带来流量的无用爬虫,比如宜搜蜘蛛(YisouSpider)(最新补充:宜搜蜘蛛已被UC神马搜索收购!所以本文已去掉宜搜蜘蛛的禁封!)。最近张戈发现nginx日志中出现了好多宜搜等垃圾的抓取记录,于是整理收集了网络上各种禁止垃圾蜘蛛爬站的方法,在给自己网做设置的同时,也给各位站长提供参考。

一、Apache

①、通过修改 .htaccess文件

修改网站目录下的.htaccess,添加如下代码即可(2种代码任选):

可用代码 (1):

|

1 2 3 |

RewriteEngine On RewriteCond %{HTTP_USER_AGENT} (^$|FeedDemon|Indy Library|Alexa Toolbar|AskTbFXTV|AhrefsBot|CrawlDaddy|CoolpadWebkit|Java|Feedly|UniversalFeedParser|ApacheBench|Microsoft URL Control|Swiftbot|ZmEu|oBot|jaunty|Python-urllib|lightDeckReports Bot|YYSpider|DigExt|HttpClient|MJ12bot|heritrix|EasouSpider|Ezooms) [NC] RewriteRule ^(.*)$ - [F] |

可用代码 (2):

②、通过修改httpd.conf配置文件

找到如下类似位置,根据以下代码 新增 / 修改,然后重启Apache即可:

|

1 2 3 4 5 6 7 |

DocumentRoot /home/wwwroot/xxx <Directory "/home/wwwroot/xxx"> SetEnvIfNoCase User-Agent ".*(FeedDemon|Indy Library|Alexa Toolbar|AskTbFXTV|AhrefsBot|CrawlDaddy|CoolpadWebkit|Java|Feedly|UniversalFeedParser|ApacheBench|Microsoft URL Control|Swiftbot|ZmEu|oBot|jaunty|Python-urllib|lightDeckReports Bot|YYSpider|DigExt|HttpClient|MJ12bot|heritrix|EasouSpider|Ezooms)" BADBOT Order allow,deny Allow from all deny from env=BADBOT </Directory> |

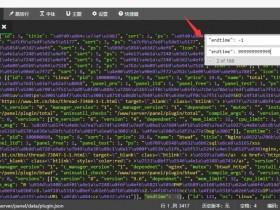

二、Nginx代码

进入到nginx安装目录下的conf目录,将如下代码保存为 agent_deny.conf

cd /usr/local/nginx/conf

vim agent_deny.conf

然后,在网站相关配置中的 location / { 之后插入如下代码:

|

1 |

include agent_deny.conf; |

如:

|

1 2 3 4 5 6 7 8 |

[marsge@Mars_Server ~]$ cat /usr/local/nginx/conf/zhangge.conf location / { try_files $uri $uri/ /index.php?$args; #这个位置新增1行: include agent_deny.conf; rewrite ^/sitemap_360_sp.txt$ /sitemap_360_sp.php last; rewrite ^/sitemap_baidu_sp.xml$ /sitemap_baidu_sp.php last; rewrite ^/sitemap_m.xml$ /sitemap_m.php last; |

保存后,执行如下命令,平滑重启nginx即可:

|

1 |

/usr/local/nginx/sbin/nginx -s reload |

三、PHP代码

将如下方法放到贴到网站入口文件index.php中的第一个 <?php 之后即可:

四、测试效果

如果是vps,那非常简单,使用curl -A 模拟抓取即可,比如:

模拟宜搜蜘蛛抓取:

|

1 |

curl -I -A 'YisouSpider' zhangge.net |

UA为空的抓取:

|

1 |

curl -I -A '' zhangge.net |

模拟百度蜘蛛的抓取:

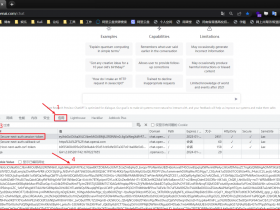

三次抓取结果截图如下:

可以看出,宜搜蜘蛛和UA为空的返回是403禁止访问标识,而百度蜘蛛则成功返回200,说明生效!

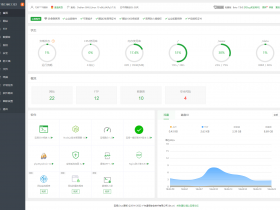

补充:第二天,查看nginx日志的效果截图:

①、UA信息为空的垃圾采集被拦截:

②、被禁止的UA被拦截:

因此,对于垃圾蜘蛛的收集,我们可以通过分析网站的访问日志,找出一些没见过的的蜘蛛(spider)名称,经过查询无误之后,可以将其加入到前文代码的禁止列表当中,起到禁止抓取的作用。

五、附录:UA收集

下面是网络上常见的垃圾UA列表,仅供参考,同时也欢迎你来补充。

![OpenAi[ChatGPT] 使用Python对接OpenAi APi 实现智能QQ机器人-学习详解篇](https://www.zxar520.com/wp-content/themes/begin5.2/timthumb.php?src=https://www.zxar520.com/wp-content/uploads/2023/02/1677441093.png&w=280&h=210&a=&zc=1)

2017年7月25日 17:20 沙发

000000000000000000000